Czas na kolejny wpis z serii SEO refleksji. Wynika on z rozmowy na FB, w której to padły stwierdzenia m.in. na temat tego, że SQT nie czyta w ogóle treści zgłoszeń o ponowne rozpatrzenie, że nawet usunięte linki należy dopisać do disavowa, zamiast np. spingować itp. – mniejsza o szczegóły. Napiszę, jak ja podeszłabym teraz do tematu analizy linków i wysłania RR.

![]()

Etap 1 – analiza linków

Niektórzy upierają się przy tym, że do analizy linków wystarczą dane z GWT. Są wśród nich jednak osoby, którym zdjęcie filtra zajęło wyjątkowo dużo czasu i prób, dlatego dla mnie jest to sugestia, że takie postępowanie może nie być do końca prawidłowe. No dobrze, sami Guglarze sugerują opieranie się tylko na ich danych, ale wyobrażacie sobie, że mogliby wskazać komercyjne narzędzie, z którym nie współpracują? 😉 Pamiętajmy, że w przykładach nienaturalnych linków, jakie podaje nam Google, można czasem znaleźć te spoza bazy w GWT. To z kolei sugeruje, że dane widoczne dla nas w GWT to tylko ułamek danych gromadzonych przez wyszukiwarkę. Zresztą wyciągnijmy sobie raporty z kilku narzędzi i zobaczmy, jak z tygodnia na tydzień do GWT dochodzą linki, których część znalazły już inne softy.

Czemu zatem nie podejść do analizy bardziej kompleksowo, uzupełniając te dane raportami z narzędzi takich jak Majestic SEO czy Ahrefs? Oba posiadają opcję wygenerowania darmowego raportu dla zweryfikowanych domen – w Majesticu jest to trochę zagmatwane, dlatego tu można znaleźć instrukcję, w Ahrefsie wystarczy ta zakładka.

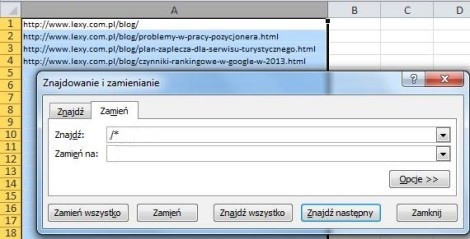

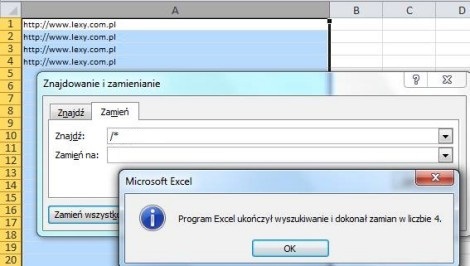

Niedocenianą przez wielu zaletą tych narzędzi jest to, że od razu dają nam pełne dane na temat strony docelowej, anchora i wiele innych parametrów, których nie dają nam dane z GWT. Dlatego aby przygotować plik do analizy, zalecam zgromadzić wszystkie te dane w 1 pliku, dodać kolumnę z nazwą domeny (będzie potrzebna do sortowania), skopiować do niej kolumnę z adresami linków, a następnie skorzystać z funkcji Excela pozwalających na skrócenie adresów stron z pełnych na same domeny.

Usuńmy też „www” z linków, a http:// zamieńmy na domain:, żeby po skończonej analizie można było część linków wrzucić do osobnego pliku disavow.

Na podstawie tak przygotowanych danych, wystarczy analizować po dosłownie 1 linku na domenę, nie musząc nawet odwiedzać wielu stron (anchory często mówią same za siebie, a na niektórych linkowanych podstronach można od razu wrzucić 404 i pominąć analizę linków prowadzących do nich), co musielibyśmy robić mając dane wyłącznie w postaci adresów stron. Szczegóły na temat sposobu analizy linków opisałam już w artykule „Jak rozpoznać toksyczne linki„, dlatego przejdźmy dalej.

Etap 2 – Działania

Z doświadczenia wiem, że odrzucane są zgłoszenia, w których analiza została wykonana prawidłowo, ale ograniczono się do zgłoszenia pliku przez narzędzie do zrzekania się niechcianych linków. Kilkakrotnie bazowałam na tym samym pliku, bez dorzucania nowych linków wyłapanych przez narzędzia, ale dopiero po usunięciu części z nich udawało się zlikwidować filtr. Dla mnie było zatem jasne, że muszę pokazać próby naprawienia sytuacji, zamiast ograniczyć się do analizy i disavowa. Fizyczne usunięcie jest wg mnie ważniejsze, a sam disavow to tylko ostatnia deska ratunku w przypadku linków, których nie da się zlikwidować.

Dlatego aby mieć szansę na pozytywne rozpatrzenie zgłoszenia, należy pokazać swoje próby uporządkowania profilu linków, a nie wyłącznie wgrać plik i liczyć na załatwienie sprawy w ten sposób. Pamiętajmy, że po drugiej stronie stoi osoba zafiksowana na punkcie wytycznych, która chce mieć przynajmniej nadzieję na to, że wyciągniemy wnioski z naszej wpadki. Postawmy się na jej miejscu – czy chcąc osiągnąć jakiś cel, np. doprowadzenie do zmiany strategii linkowania, odpuścilibyśmy ten temat lekko, czy chcielibyśmy zostać zapewnieni o planowanej zmianie? Tak tak, to coś na zasadzie wyspowiadania się ze swoich grzechów i obiecania poprawy 😉

Etap 3 – kolejka moderacji

To punkt, w którym większość opieram na zasadzie „wydaje mi się”.

Zacznę od tego, że Guglarze zapewniają o tym, że zgłoszenia są faktycznie czytane i dlatego należy się do nich przyłożyć. Jednak gdzieś kiedyś trafiłam na wypowiedź dotyczącą tego, że niektóre zgłoszenia są odrzucane automatycznie i pewnie większość z nas na miejscu Google próbowałaby całość przynajmniej częściowo zautomatyzować.

Moim zdaniem procedura rozpatrywania zgłoszeń może się odbywać w sposób półautomatyczny. Jak miałoby to wyglądać? Na przykład tak, że w momencie otrzymania przez Google naszego zgłoszenia, następuje jego automatyczna weryfikacja i sprawdzane jest, czy podjęto jakiekolwiek działania, a jeśli tak, to czy są one wystarczające do tego, aby zgłoszenie trafiło do pracownika – w końcu automat może się mylić. Wtedy też pracownik ocenia, czy może zdjąć filtr, czy nie.

Automat nie musi działać już przy pierwszym zgłoszeniu, bo wtedy nie dałoby się poinformować np. o tym, że linki dodała konkurencja, albo że kupiło się używaną domenę – takie zgłoszenia non stop byłyby odrzucane. Być może działa on albo przy kolejnych zgłoszeniach oprócz pierwszego, albo przy stronach lub na kontach, które już wcześniej w jakiś sposób podpadły, np. na danym koncie jest podpiętych wiele zafiltrowanych, a nawet zbanowanych stron, albo jest to konto dość świeże.

Jeśli jednak takiego automatu nie ma, to z czego miałoby wynikać odrzucanie części zgłoszeń bez ich czytania? Nie chciałabym wierzyć w losowość takich działań. Co myślicie na ten temat?