5 marca 2024 r. rozpoczął się pierwszy duży update Google w tym roku. Poprzedni był w listopadzie i trwał niecały miesiąc. Według oficjalnego komunikatu ze strony Google tym razem możemy się spodziewać większych wahań pozycji niż zazwyczaj.

Duża skala zmian podczas marcowego update’u wynika z tego, że kilka różnych systemów przechodzi pełną aktualizację, a dodatkowo będą one siebie wzajemnie wzmacniać. Zgodnie z zapowiedzią, pogorszy się widoczność stron sprawiających wrażenie stworzonych głównie na potrzeby SEO, a łatwiej będzie nam znaleźć wartościowe wyniki.

It’s likely there will be more fluctuations in rankings than with a regular core update, as different systems get fully updated and reinforce each other. [https://developers.google.com/search/blog/2024/03/core-update-spam-policies]

(…) we expect that the combination of this update and our previous efforts will collectively reduce low-quality, unoriginal content in search results by 40%. [https://blog.google/products/search/google-search-update-march-2024/]

Co więcej, rozbudowane zostały zasady dotyczące spamu w wyszukiwarce, co zapewne będzie się wiązało ze zwiększoną liczbą ręcznych działań nakładanych na nasze strony.

We’ll take action on more types of these manipulative behaviors starting today. While our ranking systems keep many types of low-quality content from ranking highly on Search, these updates allow us to take more targeted action under our spam policies. [https://developers.google.com/search/blog/2024/03/core-update-spam-policies]

Już teraz pojawiają się pierwsze zgłoszenia na ten temat, więc warto zalogować się do Google Search Console i przejrzeć statusy wszystkich stron po kolei. Poniżej znajduje się widok, który chciałabym zobaczyć za każdym razem 😉 Wam życzę tego samego.

źródło: Google Search Console

March 2024 core update

Z dnia na dzień zrobiło się głośno o aktualizacji w Google. Roger Monti z Search Engine Journal stwierdził, że to update na skalę Pandy i Pingwina. Dodaje on, że sporo osób narzeka na całkowite zniknięcie z indeksu ich stron, a nawet całych sieci witryn. Jedni dostają powiadomienia mailowe o nałożeniu ręcznej kary, inni widzą komunikat dopiero po przejściu do GSC, jeszcze innym pozycje spadają, zanim jeszcze pojawi się oficjalne potwierdzenie.

Aktualizacja rozpoczęła się 5 marca 2024 r. i zgodnie z planem ma potrwać ok. miesiąca. Aktualnie wdrażane zmiany zdają się być efektem wniosków wyciągniętych z wdrożonej w 2022 r. aktualizacji helpful content update.

In 2022, we began tuning our ranking systems to reduce unhelpful, unoriginal content on Search and keep it at very low levels. We’re bringing what we learned from that work into the March 2024 core update. [https://blog.google/products/search/google-search-update-march-2024/]

Z pełnej treści zacytowanego powyżej artykułu wynika, że na celowniku będą strony, które:

- zawierają mało przydatne treści;

- są słabo oceniane pod kątem UX;

- są zbyt mocno nastawione na SEO, a nie na użytkownika, co może potwierdzać wyjątkowo mocne dopasowanie treści pod kątem mocno sprecyzowanych zapytań.

Słowa kluczowe charakterystyczne dla tej aktualizacji to: unoriginal + low-quality content. To one zostaną potraktowane najostrzej.

March 2024 spam update – moja interpretacja

Nie jest to jedyna zmiana wdrażana w tym miesiącu. Oprócz poprawy jakości wyników wyszukiwania wprowadzone zostały zmiany w polityce dotyczącej spamu w wyszukiwarce.

We’re updating our spam policies to keep the lowest-quality content out of Search, like expired websites repurposed as spam repositories by new owners and obituary spam. [https://blog.google/products/search/google-search-update-march-2024]

Jednym z aktualizowanych w tej chwili systemów jest ten przeznaczony do detekcji spamu. Zachęcam w szczególności do zapoznania się z poniższymi informacjami:

- Nadużycie wygasłej domeny

Nadużycie wygasłej domeny to sytuacja, gdy wygasła nazwa domeny jest kupowana i ponownie wykorzystywana do manipulowania rankingami wyszukiwania przez hostowanie treści, które mają znikomą wartość lub nie mają dla użytkowników żadnej wartości. [https://developers.google.com/search/docs/essentials/spam-policies?hl=pl#expired-domains]

Kiedy jednak dochodzi do… nadużycia?

Z przykładów podanych pod powyższym linkiem mogę wnioskować, że nie chodzi o wszystkie przypadki wykorzystywania expirek, a jedynie o te z zawartością, która stanowiłabym problem nawet na świeżych domenach. Jeśli za przykład podawany jest zakup domeny należącej dawniej do szkoły i przeznaczenie jej na stronę kasyna, to zapis ten nie powinien nikogo dziwić. Podobnie jest ze sprzedażą produktów medycznych w ramach domeny używanej dawniej przez organizację charytatywną. To dlatego sekcja ta nie dotyczy używania expirek w ogóle, ale nadużywania płynącej z nich mocy do wykorzystania ich na inne cele, które raczej nie będą cieszyły się zbliżoną wiarygodnością.

Moim zdaniem nadal warto testować moc wygasłych domen, ale przede wszystkim na potrzeby serwisów o tej samej tematyce. Tylko w ten sposób możemy wykorzystać pełen potencjał linków z anchorami zgodnymi zarówno z historyczną, jak i aktualną (czy też przyszłą) wersją strony.

- Nadużywanie treści na dużą skalę

W tym punkcie pewną kontrowersję może budzić pierwszy z przykładów, który dotyczy treści generowanych przez AI. Ale spokojnie: końcówka tego zdania może nieść ważniejsze przesłanie.

Korzystanie z narzędzi generatywnej AI lub innych podobnych narzędzi do generowania wielu stron bez dodatkowej wartości dla użytkowników. [https://developers.google.com/search/docs/essentials/spam-policies?hl=pl#scaled-content]

No właśnie. Znowu wszystko rozbija się o masowe działania wątpliwej jakości, czyli to, z czym Google walczy od lat. Już na początku tej sekcji czytamy o tym, że:

Nadużycia na dużą skalę dotyczące treści polegają na wygenerowaniu wielu stron przede wszystkim po to, aby manipulować rankingami wyszukiwania, a nie pomagać użytkownikom. [https://developers.google.com/search/docs/essentials/spam-policies?hl=pl#scaled-content]

Zdaje się, że przeciętna strona, która niesie pewną wartość dla użytkowników, nie powinna zostać dotknięta tą aktualizacją. Jak będzie w praktyce? Czas pokaże. Na razie jest zdecydowanie za szybko na wyciąganie wniosków, nawet jeśli zauważyliśmy już spore tąpnięcia w rankingu.

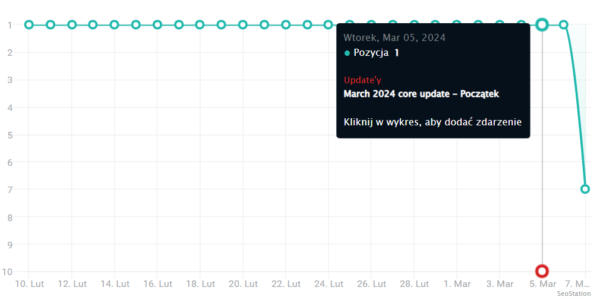

źródło: SeoStation.pl

Gorzej, jeśli na naszych kontach w GSC pojawiła się już konkretna informacja w postaci nałożenia kary (tzw. ręczne działania).

- Nadużywanie reputacji witryny

Ta sekcja została opisana najbardziej szczegółowo, a dotyczy przede wszystkim hostowania landingów z treściami, na które główny serwis nie ma zbytniego wpływu. Są one zamawiane na mocnych domenach, dzięki którym takie podstrony mogą zyskać największe korzyści z punktu widzenia SEO, mimo że nie stanowią większej wartości dla przeciętnego użytkownika danej witryny.

Nadużywanie reputacji witryny polega na tym, że strony osób trzecich są publikowane bez nadzoru lub zaangażowania ze strony witryny hostującej, a celem jest manipulowanie rankingiem w wynikach wyszukiwania z wykorzystaniem sygnałów rankingowych tej witryny. [https://developers.google.com/search/docs/essentials/spam-policies?hl=pl#site-reputation]

Wydaje mi się, że ten punkt może się odnosić zarówno do landingów zamieszczonych w katalogu, całych subdomen, jak i artykułów sponsorowanych, które mają znikomy związek z główną zawartością serwisu i w związku z tym raczej nie zainteresują one jej przeciętnego czytelnika. Nie jest natomiast uznawany za problematyczny poniższy rodzaj współpracy.

Kolumny, opinie, artykuły i inne materiały redakcyjne, w przypadku których występuje bliska współpraca lub recenzja ze strony hostującej. [https://developers.google.com/search/docs/essentials/spam-policies?hl=pl#site-reputation]

Znowu nacisk jest kładziony na wartość dla czytelnika i ścisłą współpracę pomiędzy obiema stronami, zamiast niekontrolowanego publikowania treści dostarczonych przez osoby czy firmy z zewnątrz.

Co dalej?

Na razie czekamy na więcej danych o zmianach pozycji i na zakończenie wdrażania aktualizacji. Warto w międzyczasie zwiększyć aktywność na branżowych forach i grupach w social mediach, aby zorientować się, jakie zmiany zauważają inne osoby w branży oraz z czym je wiążą. Polecam w szczególności:

- seowcy (grupa na FB)

- forum.optymalizacja.com

Na co zwracać uwagę? Czy lecą głównie młodsze, czy również starsze strony? Te oparte głównie na treściach generowanych przez AI, czy niezależne od tego, jak mocno wspieramy się automatyzacją w tym zakresie? Obrywają serwisy, które mają już coś na sumieniu, czy również te białe niczym śnieg?

Pamiętajmy, że zmiana polityki antyspamowej to tylko jeden z punktów marcowego update’u. Aktualizacji podlega cały algorytm, dlatego może się okazać, że strony zgodne z zasadami dotyczącymi spamu stracą widoczność tylko (albo aż) w wyniku zmian w wartości poszczególnych czynników rankingowych (np. znaczenie TITLE, kolejności słów kluczowych, ich trafności względem zawartości strony, zaufania autora itp.).

Informacja o zakończeniu wdrażania aktualizacji pojawi się m.in. na stronie https://status.search.google.com/summary

źródło: status.search.google.com/summary