W ostatnim artykule o mitach SEO wspomniałam o tym, że Google zlicza linki z niezaindeksowanych stron (z metatagiem noindex). Ciekawiło mnie, czy takie linki są traktowane w identyczny sposób jak te z pozostałych stron i – jak się okazało – tak właśnie jest, a więc również za nie można dostać filtr.

Sytuacja wyglądała następująco… na jednej ze stron wrzuciłam parę artykułów z Artelisa (7 tekstów na 101 łącznie). Jak można się domyślić, w większości takich tekstów znajdują się linki wychodzące wstawione w sposób typowy dla precli. Biorąc pod uwagę zarówno fakt powielania treści, jak i tego, że to nie ja wybierałam jakie linki chcę zamieścić w artykułach i jak one będą wyglądać, ustawiłam dla tych podstron metatag noindex (ale bez nofollow).

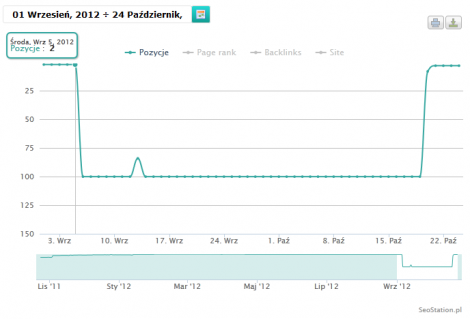

Wszystko było w porządku do początku września, kiedy na stronę został nałożony filtr za linki wychodzące. 6 września wszystkie frazy poleciały poza top 100 – na wykresie widać jedną z mniej konkurencyjnych zajmujących wcześniej 2 pozycję.

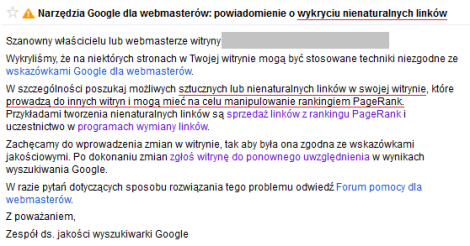

Dzień później otrzymałam powiadomienie w narzędziach dla webmasterów.

W pierwszej kolejności usunęłam linki z sidebara, chociaż dziwiło mnie ukaranie strony właśnie za nie. Linków było niewiele, wszystkie tematyczne, prowadzące m.in. do kilku tematów na forum tematycznym. Rezultat – zgłoszenie odrzucone, strona nadal naruszała wytyczne. W dalszej kolejności zajęłam się podstronami z wpisami z Artelisa. Co prawda już wcześniej pamiętałam o tym, że dodałam na nich noindex, ale dopiero teraz dodałam także nofollow i wysłałam kolejne zgłoszenie.

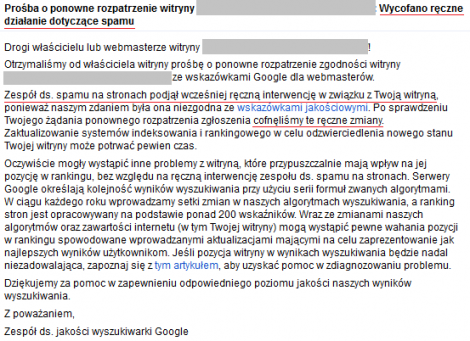

19. października otrzymałam systemową informację o tym, że przyjęli zgłoszenie, 20. pozycje zaczęły wracać na stare miejsce, a 23. dostałam potwierdzenie zdjęcia filtra.

Zastanawia mnie, czy decydująca była tu jakość stron docelowych (były to zarówno porządne strony, jak i strony sklepów z PP albo z ofertami produktów) czy sam sposób linkowania typowy dla precla. Każdy z artykułów zawierał stopkę linkującą do Artelisa jako do źródła – akurat to jest moim zdaniem zupełnie naturalne działanie, które jest także zalecane przez samo Google w celu wskazania wyszukiwarce oryginału tym bardziej, że link kierował do konkretnego artykułu, a nie np. strony głównej. Oprócz tego w tekstach znajdowało się od 1 do nawet 6 linków z anchorami mocno zoptymalizowanymi pod kątem SEO. I stawiałabym bardziej na to.

Niektórzy właściciele precli po nałożeniu filtra na ich strony zastanawiają się nad tym, czy nie zmniejszyć liczby linków dopuszczalnych w jednym tekście, albo nie wprowadzić większej liczby artykułów bez odnośników dla większego zróżnicowania. Niestety mój przypadek pokazał, że filtr można dostać nawet mając dosłownie kilka takich tekstów z nienaturalnymi wg Google linkami – tylko w 5 na 7 tekstów znajdowały się linki wychodzące. Ciekawi mnie zatem, czy komukolwiek udało się odfiltrować precla innym sposobem niż całkowitym usunięciem linków lub dodaniem do nich wszystkich nofollow.