Temat depozycjonowania poruszałam ostatnio w artykule sprzed roku, jednak postanowiłam po raz kolejny zwrócić uwagę na dość istotną – przynajmniej w moim odczuciu – kwestię związaną z nieświadomymi działaniami i ich rezultatem.

Temat depozycjonowania poruszałam ostatnio w artykule sprzed roku, jednak postanowiłam po raz kolejny zwrócić uwagę na dość istotną – przynajmniej w moim odczuciu – kwestię związaną z nieświadomymi działaniami i ich rezultatem.

Do ponownych przemyśleń na temat depozycjonowania skłoniła mnie rozmowa na FB (a raczej afera wywołana przez Sebastiana, który zarzucał rozmówcom brak zrozumienia tematu i brak własnego zdania). Kontrowersje wokół tematu (zarówno we wspomnianej, jak i w wielu innych rozmowach) depozycjonowania wiążą się z 2 sprawami:

- aspekty prawne – co prawda sama uważam, że jeśli podejmuje się jakiekolwiek działania, które mają na celu zaszkodzić innym (w tym linkowanie), to jest szansa aby podciągnąć je pod działania nieuczciwej konkurencji. Problem w tym, jak w praktyce wyglądałaby sprawa przeciwko depozycjonowaniu… ale nie na tym chciałam się skupić w tym wpisie tym bardziej, że o tym mógłby się wypowiedzieć prawnik, a nie ja;

- odmienne zdania na temat skuteczności depozycjonowania – dla mnie sprawa jest prosta: Czy linki przychodzące mogą szkodzić? Mogą, więc nie ma znaczenia, kto je zdobywa – czy osoba związana z serwisem, czy konkurencja. Tu nie ma nic więcej do zrozumienia.

Tyle słowem wstępu, bo to, na czym chciałam się skupić, to nieświadome działania mogące nam zaszkodzić.

Tak bardzo nagłaśnia się temat celowych prób zaszkodzenia konkurencji (które – przynajmniej w moim odczuciu – zdarzają się od święta), że zapominamy o realnym problemie, z którym może się spotkać każdy z nas i którego już raczej nie podciągnie się pod działania niezgodne z prawem.

Każdy, kto prowadzi serwis z tzw. user-generated content, jest potencjalną ofiarą. Nasi użytkownicy chcąc sobie „pomóc” pozycjonując profil na forum, ofertę w serwisie ogłoszeniowym lub artykuł, zdobywając linki z wszelkich możliwych źródeł. Niezależnie od tego, czy są to osoby, które poczytały tylko trochę o pozycjonowaniu czy takie, które siedzą w temacie już dość długo, wśród nich znajdą się tacy, który postanowią dopalić swoje podstrony SWLem czy Scrapeboxem. Ba, teraz wystarczy dodać linka do swojego artykułu na Wikipedii, aby zarówno treść materiału, jak i link, pojawiły się w setkach kopii.

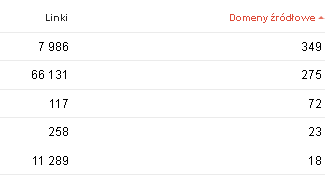

Proponuję, aby każdy z nas zajrzał teraz do narzędzi dla webmasterów albo innego narzędzia do analizy linków i sprawdził najmocniej podlinkowane podstrony. Czy są wśród nich podstrony z dużą liczbą domen linkujących? To właśnie po nich najszybciej można sprawdzić, czy w profilu nie mamy podejrzanych linków.

Zerknijmy w szczegóły i sprawdźmy, skąd pochodzą te linki. Zapewne w dużej części będą one znajdowały się na stronach, których Google wolałoby w ogóle nie mieć w indeksie. Czy jednak na pewno wygląda to na próbę depozycjonowania naszego serwisu, czy właśnie na próbę wzmocnienia podstron należących do naszych użytkowników? Założę się, że w większej części padnie druga odpowiedź i to właśnie to jest działanie, którego możemy doświadczać na co dzień. Na domiar złego jest to działanie podejmowane przez cały czas istnienia strony, a nie tylko od święta, kiedy ktoś postanowi „dopalić” stronę masowo pozyskanymi linkami i kiedy wyszukiwarki faktycznie mogą to uznać za próbę zaszkodzenia stronie, ignorując te linki.

I teraz pytanie – co zrobić? Wg starej zasady Google, nie powinniśmy skupiać się na wyszukiwarkach, tylko na dostarczaniu ciekawych treści. Tyle że obecna polityka Google nie pozwala nawet, aby trzymać się tej zasady. Mamy bowiem do wyboru:

- zignorować duże ilości podejrzanych linków i wrócić do pracy nad ulepszaniem i rozwijaniem strony, ryzykując nagłą utratę ruchu w wyniku filtra;

- zapomnieć o rozwijaniu strony, a zamiast tego spędzić kilka godzin na szczegółowej analizie linków, próbie oczyszczenia profilu, a nawet zgłoszeniu części przez disavow… ewentualnie zapomnieć o finansowaniu rozwijania strony na rzecz sfinansowania zlecenia komuś takich działań.

Do tego oczywiście dochodzi systematyczne monitorowanie nowych backlinków. Czy to nie paranoja? Osoby siedzące w temacie wiedzą, że muszą mieć rękę na pulsie i pilnować wszystkiego, starając się znaleźć złoty środek pomiędzy zaproponowanymi wyżej działaniami. Ale już przeciętny Kowalski nie musi tego wiedzieć, a z kolei duża firma również wolałaby płacić za konkretne działania mające na celu podniesienie pozycji, a nie za tracenie czasu na ciągłe monitorowanie linków zdobywanych przez osoby niepowiązane z serwisem i działania zabezpieczające przed szkodliwością cudzych linków, z którymi Google sobie nie może poradzić.

Podsumowując – linki przychodzące mogą szkodzić, a szkodliwe działania mogą być podejmowane nie tylko przez konkurencję, ale także przez przypadkowe osoby, które nie zdają sobie sprawy z konsekwencji.

Na zakończenie dam tylko małą wskazówkę, aby usuwać podstrony podlinkowane z podejrzanych źródeł i zostawiać na nich 404. Teoretycznie powinno to całkowicie wyeliminować wpływ tych linków na serwis. Jak jest w praktyce? Mogę jedynie powiedzieć, że sama stosuję to rozwiązanie na swoich stronach bez dodatkowych zabezpieczeń w postaci próby usuwania czy zgłaszania linków do usuniętych podstron i jak na razie nie miałam problemów z filtrami na tych stronach. Nie mam jednak 100% pewności, że to zawsze wystarczy.

Jeśli nie da się ustawić 404, wtedy wyciągamy backlinki do danej podstrony i podejmujemy standardowe działania polegające na oczyszczeniu profilu linków… można też po prostu skontaktować się z użytkownikiem naszego serwisu z prośbą o usunięcie linków, ale w moim przypadku to nie działało (właściciel strony zlecał pozycjonowanie i nie rozumiał kompletnie, o czym do niego piszę). Na pewno nie zalecam pozostawiania sprawy samej sobie i czekania, czy uda się ominąć filtr. Więcej szczegółów na temat zabezpieczania się przed opisanymi tu działaniami znajdziecie we wpisie Zauważyłeś próby depozycjonowania? Reaguj szybko.