Wypuszczanie kolejnych zwierzaków z Google ZOO wywołuje za każdym razem spore zamieszanie w branży. Na forach od razu pojawiają się komentarze na temat tego, komu spadły pozycje, a komu wzrosły i praktycznie zawsze można trafić na osoby podkreślające, że wzrosty pozycji zawdzięczają stosowaniu bezpiecznych technik (nierzadko określając je mianem działań White Hat SEO). Ledwo jedna aktualizacja zostanie w pełni wdrożona, a już pojawiają się porady na temat tego, jak „wyjść z Pingwina” albo nie dać mu się przy kolejnej aktualizacji. Wszystko kręci się wokół update’ów nastawionych na karanie niegrzecznych i nagradzanie grzecznych seowców. Tyle że ci grzeczni mogą sobie nie zdawać sprawy z tego, że nie tylko Panda czy Pingwin zagrażają stabilnym pozycjom ich stron.

W historii Google mieliśmy wiele aktualizacji nastawionych na zmianę sposobu prezentacji wyników. To są właśnie te zmiany, które dotykają niemal wszystkich stron niezależnie od tego, jakimi technikami były promowane.

Posłużę się tutaj listą aktualizacji na MOZie, aby podać dokładne daty opisywanych aktualizacji w Google:

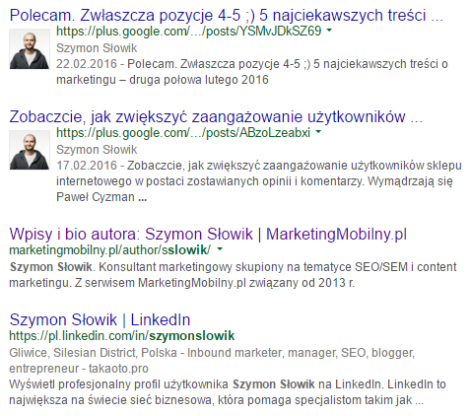

- Search plus Your World [10 stycznia 2012 r.] – tego dnia Google zaczęło personalizować wyniki, dodając do nich posty z Google+ opublikowane przez osoby z naszych kręgów. Szczegóły na ten temat zostały opisane na blogu Google i tam też można znaleźć sporo przykładów. W zasadzie nie trzeba daleko szukać, bo wystarczy posiadać konto na Google+, aby na co dzień trafiać na wyniki udostępnione przez swoich znajomych. Co ciekawe, wyniki prywatne z Google+ nie stanowią wyników dodatkowych do tych dostępnych w top 10, ale zastępują je i spychają na dalsze pozycje. Posłużę się przykładem. W pierwszej kolejności znajduje się zrzut ekranu z końcówką wyników, w których uwzględnione zostały posty z Google+, natomiast w drugim przykładzie wyłączony był tryb prywatny, a więc Google nie pobierał postów z Google+. Efektem personalizacji wyników w oparciu o dane ze wspomnianej platformy, jest zepchnięcie publicznych wyników na kolejną stronę.

Wiele osób może stwierdzić, że nie ma się czym przejmować, ponieważ Google+ nie zyskał tak dużej popularności, aby obawiać się dominacji wyników prywatnych. A co jeśli akurat w naszej branży znajdują się osoby w kręgach kilkunastu lub kilkudziesięciu tysięcy osób (np. John Mueller z liczbą 54 365 obserwujących go osób), które są zarazem naszymi potencjalnymi klientami? I co, jeśli ta osoba wspomni o naszym serwisie i tym samym pojawi się on w wynikach spersonalizowanych u osób, które go dodały? A może sami mamy szansę prowadzić oficjalny profil, który zdobędzie tak szerokie grono obserwujących osób? Warto się nad tym zastanowić.

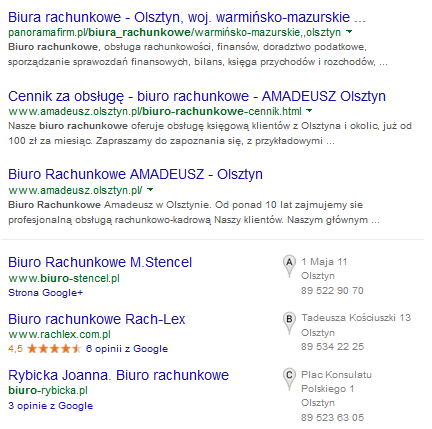

//aktualizacja: Jest rok 2019 r. i na kwiecień zaplanowane jest całkowite zamknięcie usługi Google+. Natomiast spersonalizowanych wyników z tej platformy już od dawna nie ma w Google. - Venice Update [27 luty 2012 r.] – wspominam sobie stare, dobre czasy, kiedy można było zajmować topowe pozycje niezależnie od tego, gdzie znajduje się internauta. Żeby uzyskać wyniki lokalne, trzeba było dopisać nazwę miejscowości do szukanej frazy, bo tylko wyniki z mapek były dostosowane do lokalizacji. Ta aktualizacja sporo namieszała w tej kwestii, bo od jej wprowadzenia personalizacja w oparciu o lokalizację dotyczyła także standardowych wyników organicznych. Oczywiście nie dla wszystkich fraz, bo jeśli szukam np. pościeli bądź prezentów świątecznych, prędzej będę chciała trafić na oferty sklepów internetowych niż najbliższych sklepów stacjonarnych. Jednak już szukając pośrednika nieruchomości czy biura księgowego, intencją internauty jest zazwyczaj znalezienie biur działających na terenie jego miejscowości. W rezultacie strona na 1. czy 2. pozycji w Olsztynie może zajmować np. 30 pozycję z każdej innej lokalizacji.

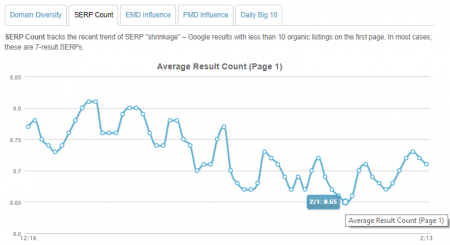

Jedni byli zadowoleni z tej zmiany (w końcu małe biznesy miały szansę przebić się wśród gigantów), dla innych powodowało to problemy tym bardziej, że długo byli przyzwyczajeni do starych i stabilnych wyników, aż tu nagle z dnia na dzień musieli kombinować, jak sobie z tym poradzić. Dodam, że do podglądu wyników wyszukiwania w różnych miejscowościach przyda się narzędzie http://adwords.google.com/anon/AdPreview - 7 wyników w „top 10” [14 sierpnia 2012 r.] – w okresie pomiędzy 12 a 14 sierpnia 2012 r., ponad 18% wyników z pierwszej strony składało się z 7, zamiast 10 pozycji. Takie dane dostarczył MOZ w swojej publikacji na ten temat (fot. poniżej)

Zdarzały się także sytuacje, w których standardowych wyników było tylko 6, bo były one poprzedzone np. zestawem obrazów, które mogły zostać potraktowane przez Google jako pierwszy wynik. To nie był pierwszy ani ostatni raz, kiedy Google eksperymentowało z ilością wyświetlanych wyników. Dla zapytań brandowych, wyszukiwarka potrafi ograniczyć się do dosłownie 4 wyników.

//aktualizacja: W 2019 r. nadal widać, że średnia liczba wyników per strona waha się w granicach między 8,5 a 8,8 i to właśnie za sprawą tego, że coraz więcej fraz wyświetla tylko 7 wyników na stronie (źródło: https://moz.com/mozcast/metrics);

- grupowanie wyników z jednej domeny (ang. Domain Crowding) [21 maja 2013 r.] – dawniej bez problemu można było znaleźć zgrupowane wyniki z tej samej domeny. Pierwszy z wyników na danej stronie wyświetlał się w standardowy sposób, a kilka kolejnych wyświetlało się tuż pod nim, jednak miały większy odstęp od lewej strony. Poniżej widać przykład:

Dawało to spore możliwości w temacie zajęcia jak największej ilości miejsc tym bardziej, że wyniki były zgrupowane w ten sposób na wielu stronach wyników wyszukiwania, a więc najpierw można było znaleźć zgrupowane wyniki na 1. stronie, potem powiedzmy na 3., dalej na 7. itd. W rezultacie, jeśli dla którejś z domen występowało grupowanie wyników i wyświetlały się łącznie 3 podstrony w top 10, to skutkowało to przesunięciem wyników z 8. i 9. pozycji na 2. stronę wyników.

Bardzo łatwo było wtedy o szybkie przeskoczenie o całą dziesiątkę wyników, a wiecie jak? Jeśli jedna z podstron w mojej domenie wyświetlała się na 3. pozycji, a kolejna dopiero na 12., to wystarczyło z tą na dalszej pozycji podskoczyć o 2 wyniki, aby dostać się do top 10 i aby wynik z 3. pozycji przyciągnął do siebie kolejny, zajmując tym samym 4. pozycję. Jeśli dodać do tego brak limitów (lub lekkie limity) dla ilości subdomen w ramach tej samej domeny, można było dość łatwo zająć większość topowych wyników (np. tworząc lokalne subdomeny). Sama zalecałam optymalizację kilku (2-3) podstron na tę samą lub zbliżoną frazę właśnie po to, aby Google zgrupowało te wyniki, oraz dodatkowo utworzenie bloga w subdomenie, aby zająć kolejny wynik.

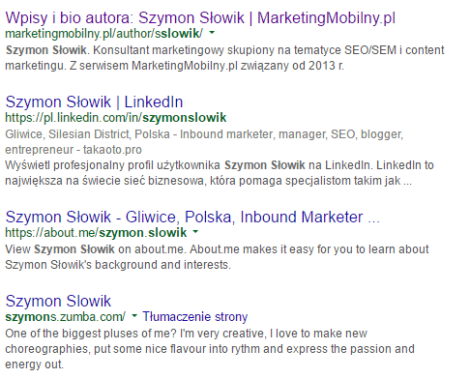

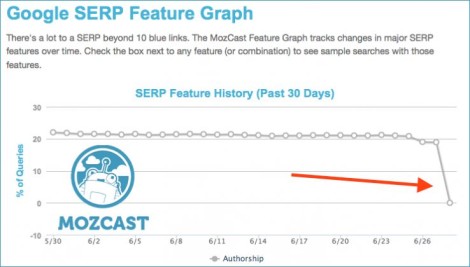

Teraz można sobie w ten sposób narobić problemów ze względu na stosowane limity (określa się to mianem kanibalizacji słów kluczowych), przez które Google wybiera najbardziej trafny wynik, a i dla subdomen są ustawione są podobne limity – gdybym np. na lexy.com.pl miała stronę z informacjami o mnie, a blog byłby dostępny w subdomenie, prawdopodobnie po wyszukaniu mojego imienia i nazwiska, w top 10 znalazłaby się tylko jedna z tych stron. Wspomniana aktualizacja miała na celu zmniejszenie skali tego zjawiska, w szczególności na 1. stronie wyników. Z czasem sytuacje, w których można było znaleźć wiele wyników z jednej domeny, ograniczyły się do zapytań brandowych i w tym przypadku widać mocną dominację wyników z domeny zajmującej 1. pozycję. Przyznam, że wprowadzenie wspomnianych limitów trochę mnie zabolało, bo jest sporo przypadków, w których w pełni uzasadnione byłoby wyświetlanie chociaż 2 wyników z tej samej domeny na jednej stronie wyników. Co prawda skrócona nazwa mojej firmy została przez Google uznana za nazwę brandu i tym samym wyświetla kilka wyników z domeny, ale już po wpisaniu nazwiska wyświetla się tylko podstrona z moją ofertą, podczas gdy powinna się wyświetlać także podstrona mojego męża. Kiedy podczas testów wyindeksowywałam tymczasowo swoje portfolio, wtedy dla naszego nazwiska pojawiała się jego oferta. Na szczęście w obu przypadkach portfolio jest tylko pozostałością po dawnej ofercie, ale myślę, że ten przykład dobrze zobrazował problem; - usunięcie zdjęć autorów z SERPów [28 czerwca 2014 r.] – wprowadzenie, a potem usunięcie Google Authorship, wpłynęło mocno na sposób prezentacji wyników wyszukiwania i mogło się odbijać na CTR. Wg danych z MozCast feature graph, z dnia na dzień 22% wyników straciło zdjęcia autorów.

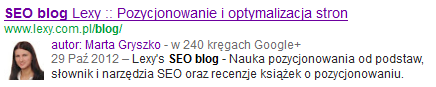

Poniżej znajduje się przykładowy wynik w czasie wyświetlania pełnych informacji (zdjęcie, imię i nazwisko, a także ilość osób, w których kręgach znajduje się autor). Nie da się ukryć, że taki sposób prezentacji przykuwał wzrok mocniej, niż standardowy wynik. Na tym etapie rezygnacji z Google Authorship usunięto same zdjęcia, ale pozostawiono informacje o autorach. Po 2 miesiącach także one zniknęły z wyników wyszukiwania.

Prezentację podobną do powyższej można zobaczyć już tylko we wpisach z Google+ – te jednak wyświetlały się tylko osobom zalogowanym na konto Google, które jednocześnie włączyły tryb prywatny i tym samym widzą wpisy osób ze swoich kręgów.

//aktualizacja: W 2019 r. zaplanowano całkowite zamknięcie usługi Google+, a dane z tej platformy już od dawna nie wyświetlały się w wynikach wyszukiwania;

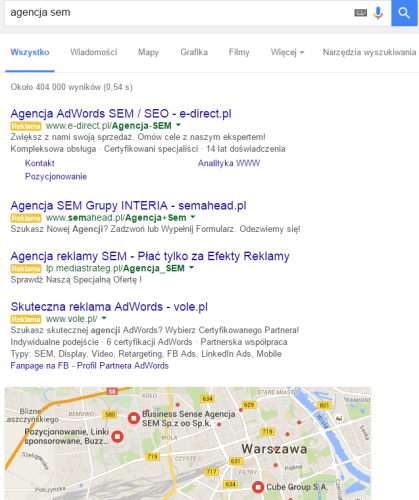

- usunięcie prawej kolumny reklam Google AdWords [23 luty 2016 r.] – ta zmiana skutkuje tym, że dla niektórych fraz wyniki organiczne zaczynają się dopiero po 4 reklamach. Jeśli dodatkowo wyświetlają się wyniki z miejsc Google, to pierwszy wynik organiczny wyświetla się dopiero pod linią przewijania. Problem jest tym większy, im więcej rozszerzeń jest dostępnych w Google Ads (dawniej: Google AdWords), np. rozszerzenia w postaci dodatkowych linków, które zajmują kolejne linijki w SERPach. Oto jeden z przykładów:

W międzyczasie pojawiały się także inne mniejsze bądź większe aktualizacje (m.in. Mobilegeddon, RankBrain). Nawet wprowadzenie rozszerzonych linków witryn wpłynęło na to, że 1. pozycja z sitelinkami skupiała na sobie uwagę (zerknijcie na trzeci screen z tego wpisu). Było także mnóstwo innych update’ów, w wyniku których pierwsze pozycje zaczynały mieć bogatsze prezentacje i zajmowały dużo więcej miejsca, niż dawniej.

Na potrzeby tego artykułu wybrałam jednak najciekawsze spośród tych aktualizacji, przez które SERPy zmieniły się dosłownie z dnia na dzień i które nie były nastawione na karanie bądź premiowanie za podejście do wytycznych wyszukiwarki. Wspomniane zmiany powinny nas wszystkich utwierdzić w przekonaniu, że nie można opierać biznesu tylko na 1 kanale ruchu (tu: bezpłatny ruch z Google), ale także aby jak najszybciej podążać za zmianami. W wielu przypadkach są one wprowadzane w pierwszej kolejności w USA (np. Pigeon Update wpływający na wyniki lokalne – można o nim doczytać w tym materiale), a dopiero po kilku miesiącach uzyskują zasięg globalny, więc możemy wtedy zareagować, zanim aktualizacja dotrze do naszego kraju.

Czy ktoś z Was ucierpiał mocno w wyniku wspomnianych tu aktualizacji? A może wręcz przeciwnie – pomogły one Waszym serwisom wybić się w SERPach?