Pamiętam, jak na początku utworzenia polskiego forum Google proponowałam wprowadzenie narzędzia do zgłaszania niechcianych linków. Wtedy nie było dużego zainteresowania tym tematem, ale od kiedy Google oficjalnie przyznało się do nakładania kar za tzw. nienaturalne linki, takich pytań było coraz więcej. Już kilka miesięcy temu narzędzie „Disavow links” pojawiło się w narzędziach dla webmasterów Bing. Pracownicy Google, pytani o wypuszczenie takiego samego narzędzia, nie zawsze byli zgodni w odpowiedziach – podczas gdy Matt Cutts wspomniał już o pracy nad tą opcją, John Mueller twierdził, że nie widzi potrzeby dla takiego udoskonalenia narzędzi dla webmasterów. Ale przejdźmy do konkretów…

W poniższym filmiku znajdują się szczegóły na temat opcji „Disavow links” w Google:

W dużym skrócie, aby przesłać żądanie zignorowania linków, należy:

1. zalogować się na swoje konto narzędzi dla webmasterów;

2. przejść do wybranej strony;

3. wejść w zakładkę Ruch -> Linki do Twojej witryny -> Źródła największej liczby linków -> Więcej, a następnie pobrać listę linków klikając w link „Pobierz listę”;

4. listę należy przejrzeć, zostawiając na niej wyłącznie te linki, których chcemy się zrzec, jak to nazywa samo Google;

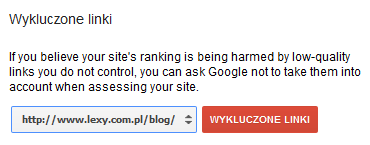

5. mając gotową listę linków do zignorowania, wchodzimy na stronę www.google.com/webmasters/tools/disavow-links-main i wybieramy jedną ze stron.

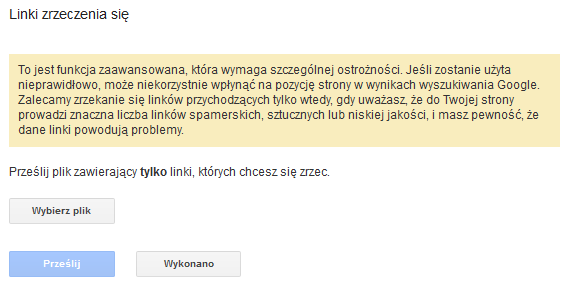

6. klikamy „Linki zrzeczenia się”, a następnie „Wybierz plik”;

7. czekamy na reakcję. Może to potrwać nawet kilka tygodni, ponieważ wyszukiwarka musi najpierw odwiedzić zgłaszane strony. Matt ostrzega przed nieuważnym stosowaniem tego narzędzia, co może doprowadzić do zignorowania wartości wszystkich linków. Ewentualne późniejsze anulowanie zgłoszenia może również zająć trochę czasu.

Korzystanie z tego narzędzia jest zalecane osobom, które otrzymały powiadomienia o wykryciu nienaturalnych linków albo mają obawy o spadek pozycji w związku z Pingwinem. Po zgłoszeniu niechcianych linków i odczekaniu tych kilku tygodni, w czasie których Googlebot przeindeksuje zgłaszane adresy, należy dodatkowo wysłać zgłoszenie ponownego rozpatrzenia. Odpowiedzi na dodatkowe pytania o narzędzie „Disavow links” znajduje się w tym wpisie.

Przyznam szczerze, że mimo że sama kiedyś nalegałam na taką opcję, w tej chwili mam obawy co do tego, że brak zgłaszania „nienaturalnych” linków może być dla Google potwierdzeniem, że faktycznie sami je pozyskaliśmy i tym samym zasłużyliśmy na filtr. To jednak taka wstępna refleksja… czas pokaże, jak to będzie wyglądało. Tak się złożyło, że mam na czym przetestować nową opcję, bo kilka SEO blogów (w tym mój) zostało przez kogoś wybrane do testów na skuteczność zafiltrowania strony przez dopalenie jej śmieciowymi linkami.

A co Wy o tym myślicie?

//edycja:

Przygotowano już poradnik dotyczący korzystania z narzędzia disavow links w Google. Na jutro planowany jest również hangout na Google+ poświęcony temu tematowi. Jego organizatorem, jak również autorem poradnika, jest Dan Petrovic.