Każdy z nas na co dzień korzysta ze stałego zestawu narzędzi SEO. Ja w dzisiejszym wpisie chcę zaprezentować kilka spośród tych dostępnych online – nie kombajnów, tylko małych narzędzi skupionych na jednej konkretnej funkcjonalności. Zachęcam również Was do dzielenia się informacjami o innych softach, które polecacie.

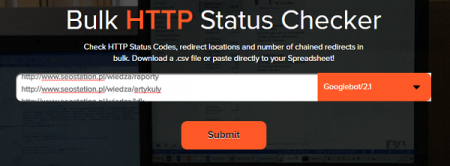

- Bulk HTTP Status & Redirect Checker

Narzędzie dostępne pod adresem www.urlitor.com pozwala na masowe odpytanie o nagłówki HTTP listy adresów, które do niego wprowadzimy, a w przypadku wykrycia przekierowań zwróci nam ich pełną ścieżkę. Wykorzystuję je często do odpytania o podstrony zaindeksowane w Google, dzięki czemu mogę szybko sprawdzić, gdzie wprowadzić poprawki.

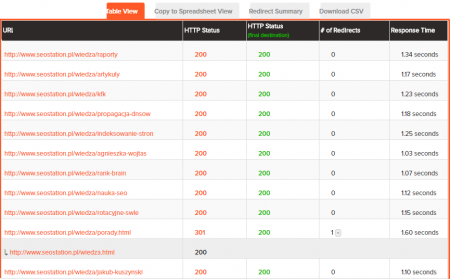

Aby z niego skorzystać, należy przejść na stronę www.urlitor.com i w polu wyszukiwania wkleić max 150 adresów do sprawdzenia. Może to być lista pobrana z Google, lista podstron wyeksportowanych z Google Analytics, z narzędzia do analizy backlinków (np. Majestic) albo bezpośrednio z mapy strony. Poniżej znajduje się przykład dla domeny seostation.pl, na której w ostatnim czasie uległa zmianie struktura adresów URL na blogu.

Jak widać, tam gdzie narzędzie trafiło na przekierowanie, można rozwinąć pełną ścieżkę przez kliknięcie w plusik w kolumnie „# of Redirects”. To, co powinno nas jednak interesować bardziej, to podstrony z nagłówkami innymi niż 200 albo 301, czyli głównie 404, które należy odpowiednio przekierować.

Pełny raport można wyeksportować m.in. do pliku CSV i tam na nim wygodnie pracować.

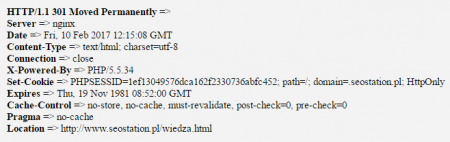

2. HTTP/HTTPS Header Check

Narzędzie www.webconfs.com/http-header-check.php jest podobne do opisanego już, ale podające bardziej szczegółowe dane i umożliwiające odpytanie tylko o 1 adres URL.

Oto wynik sprawdzania:

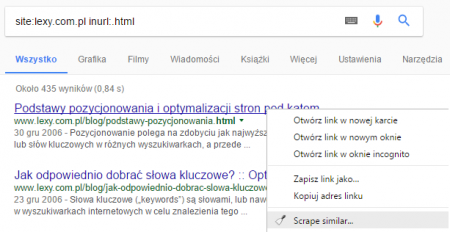

3. Rozszerzenie Scraper do Google Chrome

Wspomniałam wcześniej o odpytywaniu pierwszego z wymienionych narzędzi o zaindeksowane podstrony. Te w bardzo łatwy i szybki sposób można wyciągnąć za pomocą rozszerzenia do Google Chrome o nazwie Scraper. Wystarczy ustawić w Google wyświetlanie po 100 wyników per strona, a następnie wpisać interesującą nas komendę. Dodam, że Google od pewnego czasu mocno ogranicza ilość danych wyświetlanych dla komendy site, dlatego czasem lepiej jest odpytywać o bardziej szczegółowe komendy, np. site:lexy.com.pl inurl:.html niż po prostu o site:lexy.com.pl który może zwrócić mniej wyników. Aby to zweryfikować, najłatwiej jest wybrać dość nietypowe adresy podstron do sprawdzenia, np. te ze starej struktury adresów URL. Najpierw sprawdzamy wszystkie podstrony samym site’m, a potem doprecyzowujemy komendę dopisując do niej fragment adresu – w drugim przypadku powinniśmy uzyskać więcej wyników.

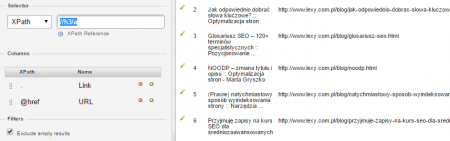

No dobrze, jak zatem wyeksportować z Google listę zaindeksowanych podstron? Wpisujemy komendę i mając włączone rozszerzenie Scraper klikamy np. na podlinkowany tytuł strony (klikając na adres, niektóre z nich – te dłuższe – mogą być ucięte i w rezultacie ich analiza niewiele nam da) prawym przyciskiem myszki i wybieramy „Scrape similar„. To pozwoli na wylistowanie tego samego elementu (w tym przypadku tytułu) ze wszystkich wyświetlonych wyników.

Otrzymujemy wynik w następującej postaci, który również możemy wyeksportować i zapisać w osobnym pliku.

Aby tak wygenerowaną listę podstron wrzucić do HTTP Status & Redirect Checkera, wystarczy wkleić adresy z drugiej kolumny raportu.

4 i 5. Narzędzia zgłaszania stron do Google

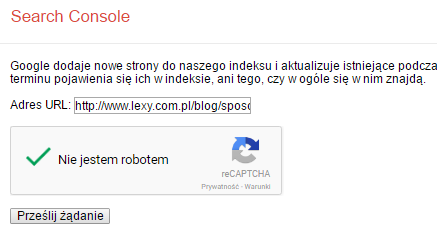

Dostępne są 2 narzędzia zgłaszania stron do indeksu Google. Pierwsze z nich jest dostępne dla zewnętrznych osób, które nie muszą być powiązane ze zgłaszaną stroną. Znajduje się ono pod adresem www.google.com/webmasters/tools/submit-url – tak, to właśnie te narzędzie, które istnieje od lat i które już wiele lat temu było uważane za nieskuteczne, a teraz wygląda na to, że działa na takich zasadach jak drugie, o którym za chwilę napiszę.

Warto przetestować szybkość działania tej metody, ponieważ z moich obserwacji wynika, że indeksacja jest możliwa dosłownie w ciągu kilku sekund. Oczywiście takie zgłoszenie nie zapewnia nam stałej indeksacji, ponieważ strona może jeszcze wiele razy wypadać i wracać do Google. Pamiętajmy również, że inaczej zachowa się strona zaindeksowana dzięki trafieniu na nią za pośrednictwem linka, który przy okazji przekaże jej moc, a inaczej jeśli wysyłamy robota Google w ten właśnie sposób.

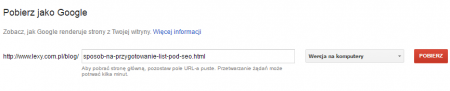

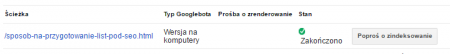

Kolejny sposób jest dostępny dla zweryfikowanych właścicieli, dlatego wymagany w tym przypadku będzie dostęp do panelu Search Console wybranego serwisu. Interesować nas będzie zakładka Indeksowanie -> Pobierz jako Google, w której należy wpisać adres zgłaszanej strony, poczekać na sprawdzenie jej stanu, a następnie kliknąć przycisk „Poproś o zaindeksowanie„.

Do wyboru wyświetlą się 2 opcje:

- Indeksuj tylko ten adres URL – miesięczny limit ilości podstron przesyłanych w ten sposób do indeksu to 500;

- Indeksuj ten adres URL i jego linki bezpośrednie – tu limit miesięczny wynosi zaledwie 10.

Warto już w momencie wpisywania adresu w narzędziu „Pobierz jako Google” odpalić logi serwera i sprawdzić, w którym dokładnie momencie Googlebot zawita na naszą stronę. Dodam, że nie zawsze czas pierwszej wizyty jest identyczny z czasem indeksacji danej strony. To, co zwróci naszą uwagę, to plik, do którego robot Google zagląda w pierwszej kolejności – będzie to plik robots.txt „mówiący” robotom, do jakich sekcji strony mogą, a do jakich nie mogą zaglądać.

6 i 7. Narzędzie do usuwania wyników z Google

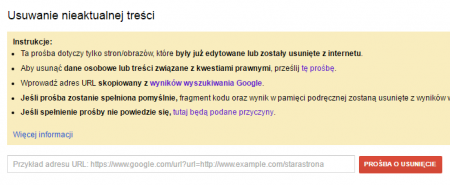

Tutaj też mamy do wyboru 2 opcje. Pierwsze z narzędzi jest dostępne dla osób niepowiązanych ze zgłaszaną stroną, a znajduje się ono pod adresem https://www.google.com/webmasters/tools/removals Nie będzie ono skuteczne dla każdego zgłoszenia, a jedynie dla tych, dla których:

- zmianie uległa zawartość strony, a my zgłaszamy w zasadzie nie prośbę o jej usunięcie, ale o jej uaktualnienie – można z tego skorzystać np. w przypadku, gdy usunęliśmy naszą zawartość z cudzej strony albo poprosiliśmy jej właściciela o zmianę lub usunięcie naszych danych. W takim przypadku zgłoszenie będzie skutkowało tym, że kopia ulegnie zmianie i znikną z niej stare dane, a tym samym wynik przestanie się wyświetlać w Google dla dawnej zawartości;

- strona została usunięta przez jej właściciela, ale jej kopia nadal znajduje się w Google – wtedy zgłoszenie będzie skutkować usunięciem wyniku z Google.

Zwróćmy uwagę na to, że Google zapisuje na podstronie www.google.com/webmasters/tools/removals wszystkie nasze zgłoszenia. Na podobnej zasadzie może gdzieś zapisywać (ale nie wyświetlać) adresy stron, które zgłosiliśmy do Google korzystając z narzędzia dodawania ich do Google przez osoby niepowiązane ze stroną. Tym samym należy z nich korzystać ostrożnie, jeśli nie chcemy, aby Google powiązało wiele naszych stron (np. zapleczowych) z naszymi kontami.

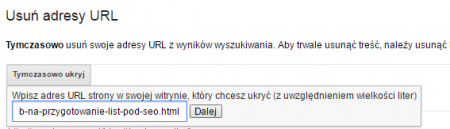

Ostatnie z opisywanych narzędzi jest dostępne z poziomu Search Console, a zatem mogą z niego skorzystać osoby z dostępem do panelu. Można przejść od razu na stronę www.google.com/webmasters/tools/url-removal i z jej poziomu wybrać serwis.

Teoretycznie bez zastosowania 404 albo noindex, wyniki zostaną usunięte tymczasowo i w każdej chwili mogą wrócić do indeksu. W praktyce jednak nie zauważyłam tego. Warto zwrócić uwagę na opcje dostępne w kolejnym kroku, wśród których istnieje m.in. możliwość ukrycia w indeksie całego katalogu, a nie tylko konkretnej podstrony.

A z jakich Wy korzystacie narzędzi?